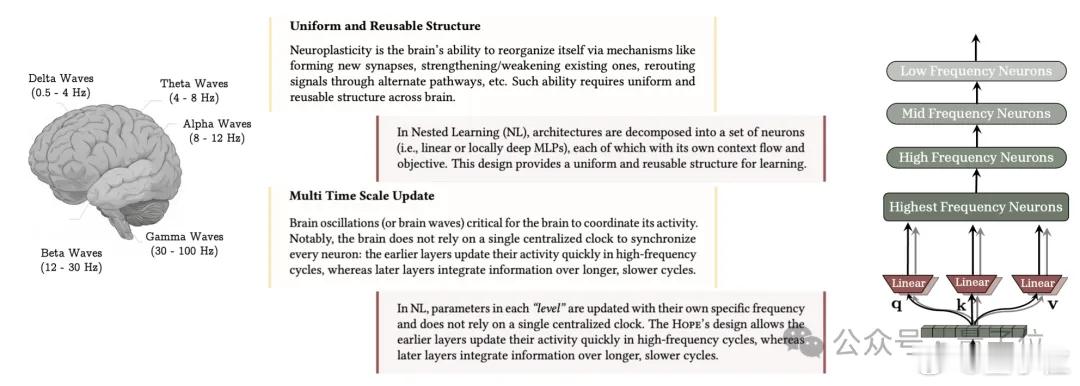

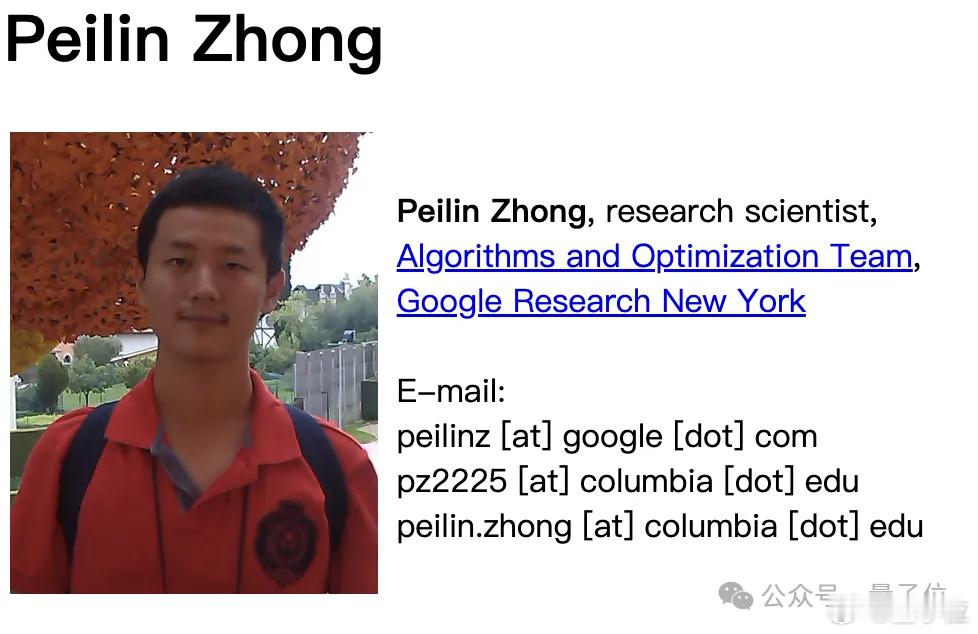

谷歌AI掌舵人Jeff Dean最近点赞了一项新研究,来自清华姚班校友钟沛林团队。这项研究提出了一个叫Nested Learning(嵌套学习,简称NL)的新范式,专门解决大语言模型的灾难性遗忘问题。简单来说,就是让模型从扁平的计算网,变成像人脑一样有层次、能自我调整的学习系统。研究团队发现,我们常用的Transformer其实只是NL的简化版,它把NL的多层级拆成了单一层级,并没发挥出多层级的优势。基于NL范式的Hope模型,在语言建模和长上下文记忆任务中的表现都优于Transformer,论文已被NeurIPS 2025接收。传统大模型有个核心痛点:像是得了顺行性遗忘症,预训练完成后就难以持续吸收新知识,只能依赖有限的上下文窗口或固化的历史参数,无法像人类一样动态积累知识。而且传统深度学习靠堆层、堆参数来提升性能,也逐渐触及瓶颈,增加网络层数往往无法带来预期中的能力提升。NL开辟了一条新路径,灵感源自大脑的记忆工作原理。人脑通过在线巩固和离线巩固两个互补的过程实现持续学习,短期记忆快速更新,长期记忆缓慢沉淀。NL把这套逻辑数字化,将机器学习模型重构为嵌套式的多层级优化体系,每个层级都有独立的上下文流和更新频率。有的快速响应实时输入数据,有的缓慢沉淀长期知识规律。基于NL范式,研究团队推出了三大核心创新:- 深度优化器:传统优化器只会按固定公式处理梯度,而NL的深度优化器能靠预处理机制提前分辨梯度性质,用MLP神经网络替代线性记忆来存储过往梯度规律,能够预判梯度变化、灵活调参。- 自我修改模型:让模型在训练过程中自主学习如何调整自身参数,面对新领域数据时能灵活适配,无需人工干预修改架构。- 连续记忆系统:将传统模型的短期长期记忆二元结构升级为多尺度记忆链,不同MLP模块按不同频率更新,分别负责存储短期细节与长期规律,实现类似人类的分层记忆管理。这些创新最终凝聚为Hope模型。测试显示,从760M到1.3B参数规模的Hope,在语言建模与常识推理任务中的表现均大幅超越Transformer、RetNet、DeltaNet等主流基线模型。在Wiki文本困惑度、PIQA物理常识推理、Winograd指代消解等多项指标上,Hope要么以更低的困惑度展现出更优的语言建模能力,要么以更高的准确率证明了更强的推理水平。钟沛林,2016年毕业于清华姚班,2021年拿到哥伦比亚大学的计算机博士学位。从2021年起,他就加入了谷歌纽约研究院,担任算法与优化团队的科学家。在进入清华姚班之前,他就已经是竞赛达人。2012年,钟沛林代表雅礼中学出征国际信息学奥林匹克竞赛,并获得当年的IOI金牌。和他同年获得金奖的,还有同为雅礼中学学子的艾雨青。有意思的是,钟沛林和艾雨青两人是发小,艾雨青是在钟沛林的影响下,走上IOI之路,两人并肩成为了那一年雅礼中学的双子星,保送至清华姚班。虽然在写NL这篇论文时,钟沛林尚在谷歌纽约研究院就职,但目前,这对双子星已前后脚入职了Meta,分别担任AI科学家和软件工程师。参考链接:research.google/blog/introducing-nested-learning-a-new-ml-paradigm-for-continual-learning/