[CL]《Actions Speak Louder than Prompts: A Large-Scale Study of LLMs for Graph Inference》B Finkelshtein, S Cucerzan, S K Jauhar, R White [Microsoft Research & University of Oxford] (2025)

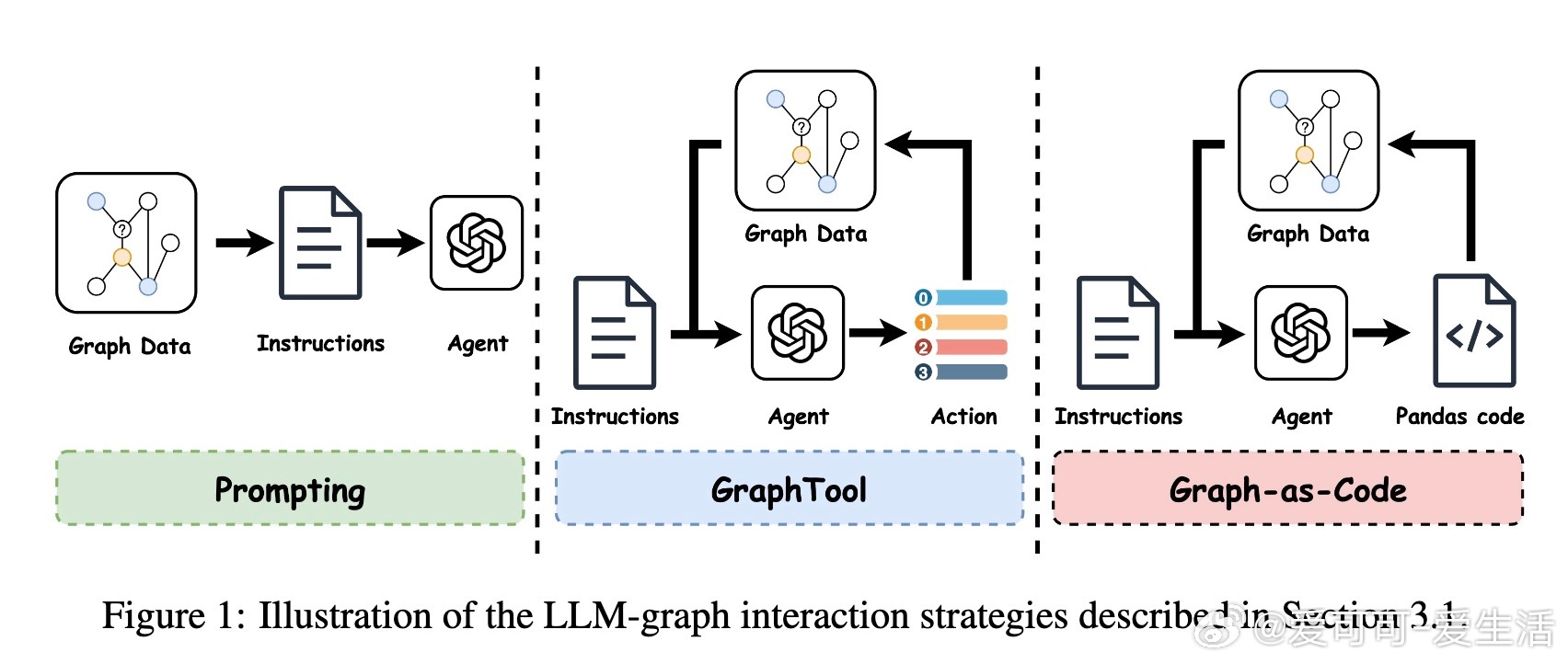

大型语言模型(LLMs)在文本丰富的图机器学习任务(如节点分类)中展现出强大潜力,尤其在欺诈检测、推荐系统等领域。最新大规模研究系统评估了LLM与图数据交互的三种策略:Prompting、Tool-use(GraphTool)、以及基于代码生成的Graph-as-Code,揭示了各自优势与适用场景。

• Graph-as-Code利用LLM的代码生成能力,通过编写并执行简洁程序灵活访问图结构、节点特征和标签,实现整体最佳性能,尤其在长文本或高节点度图中优势明显,避免了Prompting因上下文窗口限制而性能瓶颈。

• 所有交互模式在异质性(heterophilic)图上均表现良好,有别于传统观点中LLM在低同质性环境下性能下降的假设,说明LLM能有效挖掘非局部特征和结构信息。

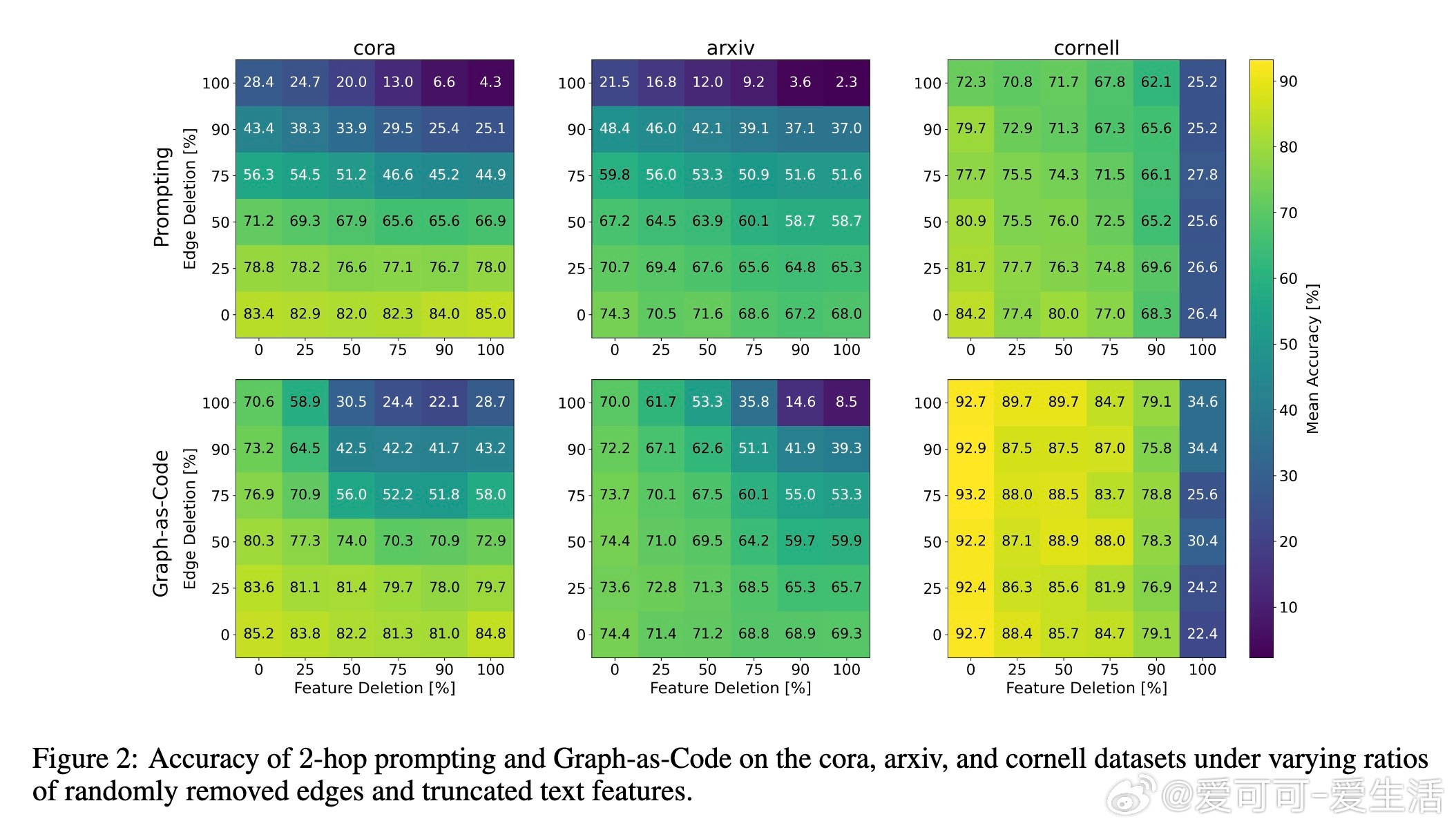

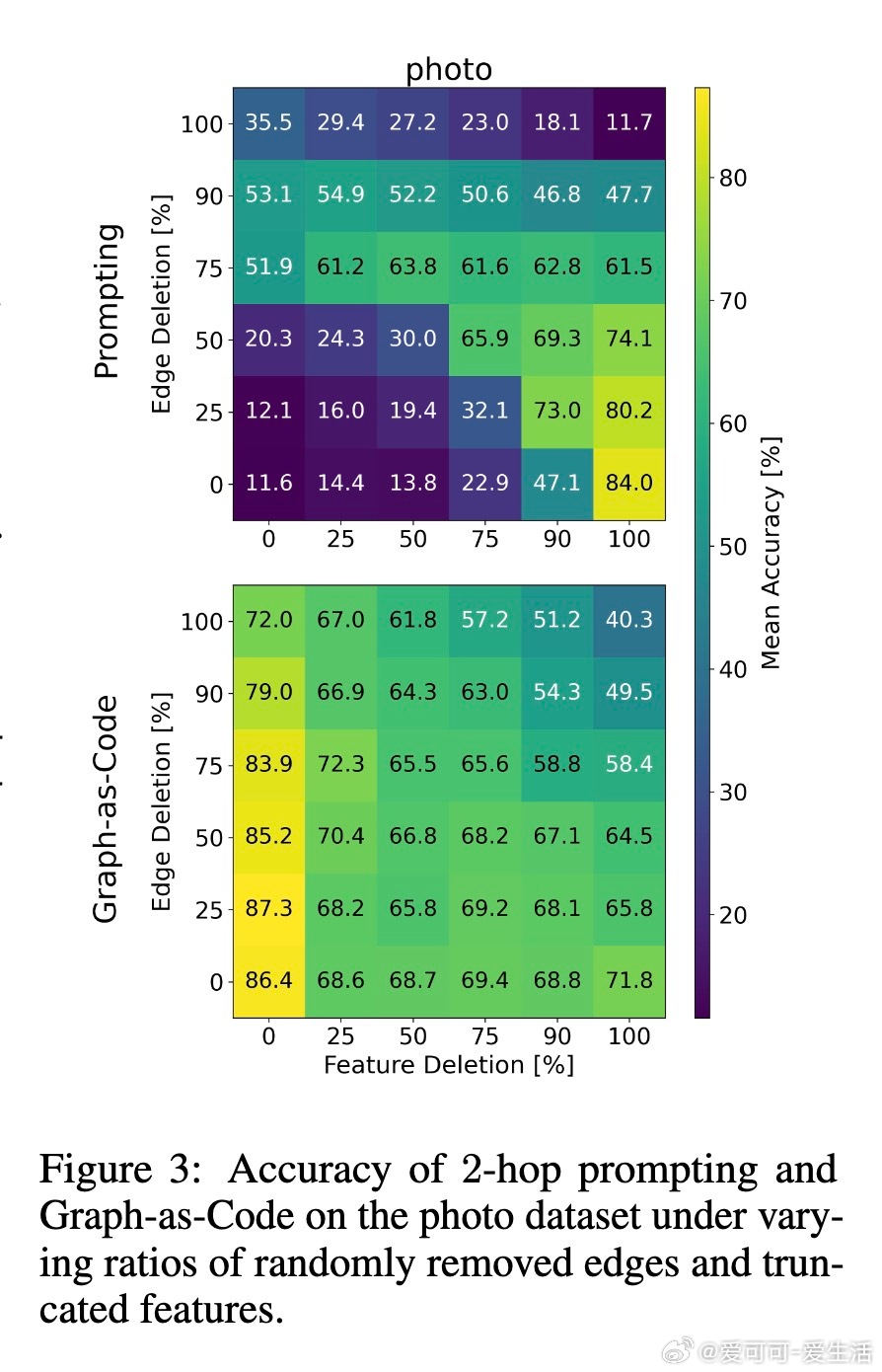

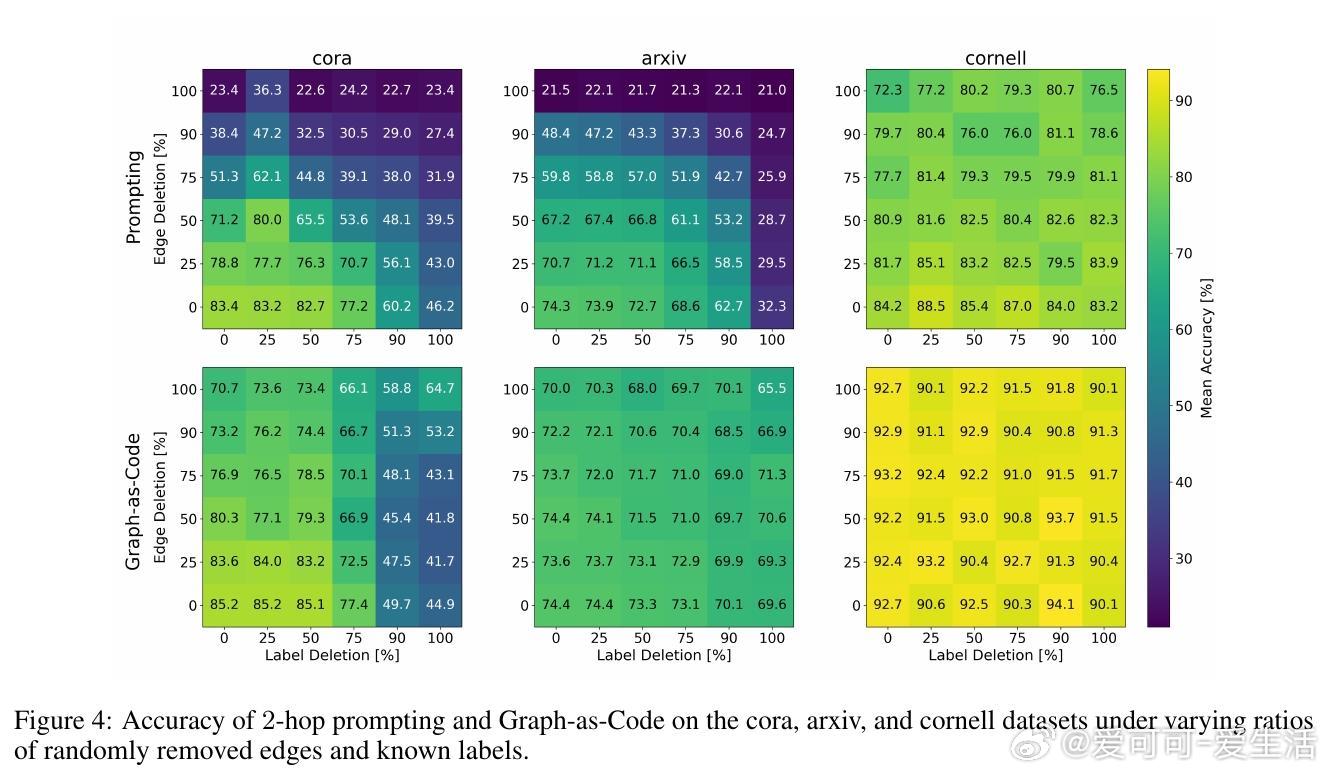

• Graph-as-Code能够动态调整对结构、特征或标签的依赖,适应输入信息的可用性和质量,表现出更强的鲁棒性和灵活性,特别是在部分信息缺失或噪声环境下。

• 规模更大的LLM和具备推理能力的版本显著提升节点分类准确率,推理能力促使模型进行更深入的多跳推断和信息整合。

• Prompting方法虽简洁但受限于上下文长度,尤其在处理长文本和高连通度图时,性能下降明显;GraphTool(工具调用)提供了迭代式交互,减少无关信息暴露,性能居中。

• 节点特征文本长度、图的同质性和节点度数是影响性能的关键因素,不同数据集类型(引用网络、电商、社交网络等)表现出不同对交互模式的偏好。

• 依赖分析显示,Prompting对结构和标签依赖较强,结构缺失时性能急剧下降;Graph-as-Code则能在结构缺失时通过特征和标签补偿,表现出更强的容错性。

• 研究首次以统一框架大规模横向比较了多种LLM-图交互模式,为未来设计高效、鲁棒的图推理系统提供了明确指导。

心得:

1. 利用代码生成的灵活交互突破了上下文窗口限制,是处理复杂图数据的关键突破口。

2. 异质性图的有效处理表明,LLM能超越传统基于邻域同质性的图学习假设,具备更广泛的适用性。

3. 灵活调整信息依赖使模型更适应实际场景中的数据不完整和噪声,提升应用稳定性。

详见🔗arxiv.org/abs/2509.18487

大型语言模型图机器学习节点分类代码生成异质图文本与结构结合