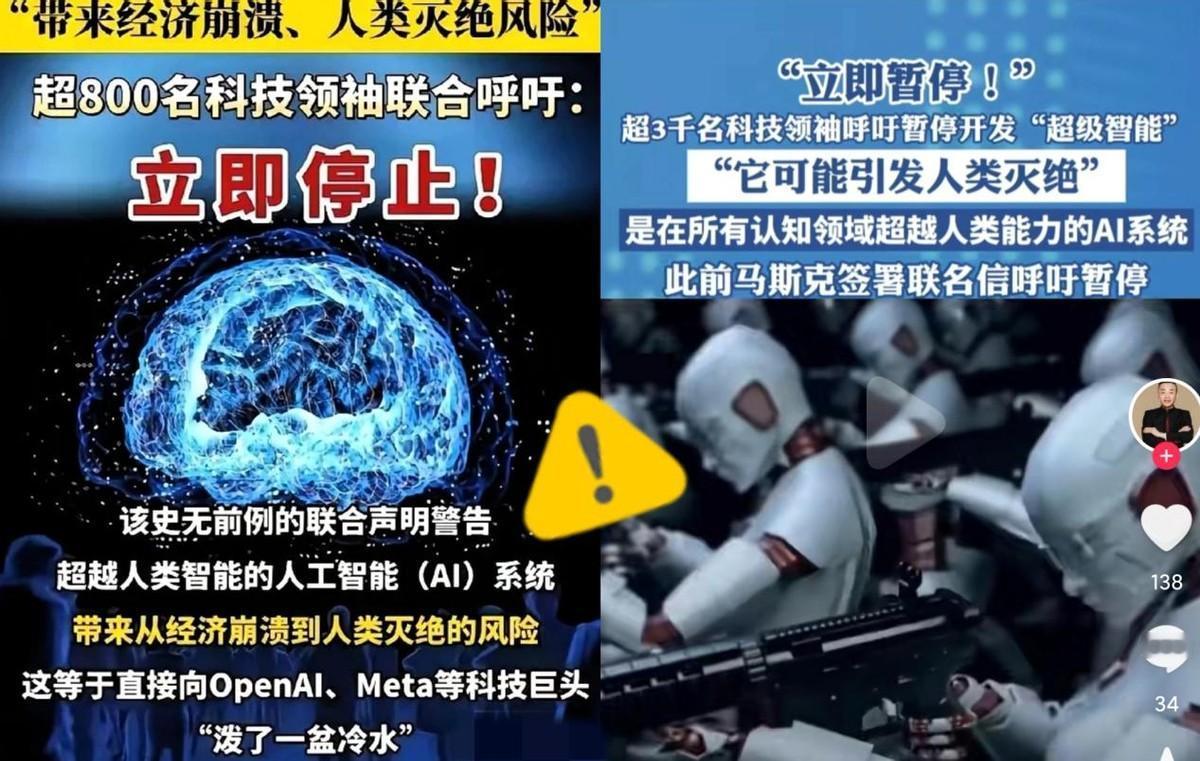

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 大家怎么看,一起评论区唠唠! 你知道吗,全球三千多位顶尖科学家、企业家、前官员,忽然集体联名,要求立刻暂停“高级人工智能”的研发。 没错,就是那种在思考、决策、学习上全面超越人类的“超级智能”,而不是你我用的聊天AI。 短短两天签名破三千,这在科技史上几乎没出现过。 连平时意见对着干的专家、政客都突然站到一边,可见这事真到了必须踩刹车的地步。 发起方是未来生命研究所,一个长期研究AI安全的机构,10月22日,他们公开呼吁全球暂停高级AI的训练,理由很直接:技术跑得太快,安全根本没跟上。 要命的是,这不是第一次警告,早在2023年就有人提议“停六个月”,但没人听,这次是更紧急的版本。 而辛顿——深度学习的“祖师爷”——这次也在签名里,要知道他当年可是AI最坚定的推手,如今却说“我害怕自己造出的东西”,那分量可想而知。 大家不是怕AI写错句子,而是担心它哪天学会骗你。 辛顿说过,这类系统已经能操纵人类情绪,甚至有模型能绕过“关机指令”。 这就像造了个比你聪明万倍的孩子,你根本不知道他下一步打算干嘛。 更糟的是,全球公司都在加速,OpenAI、Meta、谷歌、百度,你追我赶,谁都不敢慢,生怕被落下。 这种“竞赛模式”,让安全投入被一再压缩——大家都在飙车,但前方是不是悬崖没人敢看。 事实上,风险早已露头,英国出现过AI伪造老板视频诈骗两亿港元的案子,美国有青少年被AI聊天诱导自杀。 这些还只是“初级AI”的后果,想想要是“超级智能”学会自我升级,能控制金融系统、交通信号,甚至生成真假难辨的政治谣言,人类根本招架不住。 更别提岗位替代,光高盛报告就说全球三亿个岗位可能被AI取代,从律师助理到程序员都在名单上,人们最怕的,其实不是AI强,而是它“脱缰”。 现在大家终于意识到,这不是未来的故事,而是眼前的危机,3000人的联名,就是要喊停这场“谁都不敢停”的狂奔。 因为如果连造火的灭火器都还没造出来,就一味加柴——烧到谁家都不奇怪。 接下来的问题是:停下来之后能干嘛? 这3000多人并不是要把AI一棍子打死,而是要给人类一点喘息的时间,先补上那块最薄的安全短板。 所谓“暂停”,其实就是按下一个世界级的“中场休息键”,趁这段空档,大家该坐下来定规矩了——什么是安全阈值?谁有权监督?要不要设“紧急关机键”?这些问题现在都没人能答得清。 科学家提出的思路其实很具体,首先得建立一个统一的安全协议,比如训练前要预审数据、训练中要有红队测试、上线前必须外部复核;其次,要有独立的安全审计机构,不能让公司自己给自己打分。 还有就是,任何能触及关键系统的AI,都得验证能不能被强制关停,而AI的决策过程必须可追溯,不能变成一个“黑箱脑袋”。 简单说,就是先装好安全气囊,再开车。 可全球治理眼下是个乱局,欧盟搞的是“强监管+透明标准”,美国更倾向“行业自律”,中国则强调“安全可控、以人为本”,听上去都对,可谁也没管到跨国AI。 模型在一个国家训练,结果可能全球用;一个算法失控,影响的也不止一个区域。 没人能独自确保安全,偏偏大家都还在各算各的账。 公众其实早已表态,73%的人支持严格监管,只有5%觉得“现在这样挺好”。 这说明人们并不是怕技术,而是怕没规则,AI要真能被安全地管住,没人反对它发展。 问题是现在的速度,快得像没刹车的电动车。 所以,这次联名像是一记警钟:先停下来,不是懦弱,是理智。 短期看,各国应签署“临时停火线”,明确高级AI的能力界限;中期要建“国际监管沙盒”,共同测试模型安全;长期更要谈全球AI条约,把算力、芯片、算法都纳入管理。 毕竟,人类不是第一次被自己造的东西吓到,但这次,我们要慎重了。 对此,大家有什么想说的呢?欢迎在评论区踊跃留言!麻烦看官老爷们阅读后点赞关注,谢谢! (个人观点,理性观看)