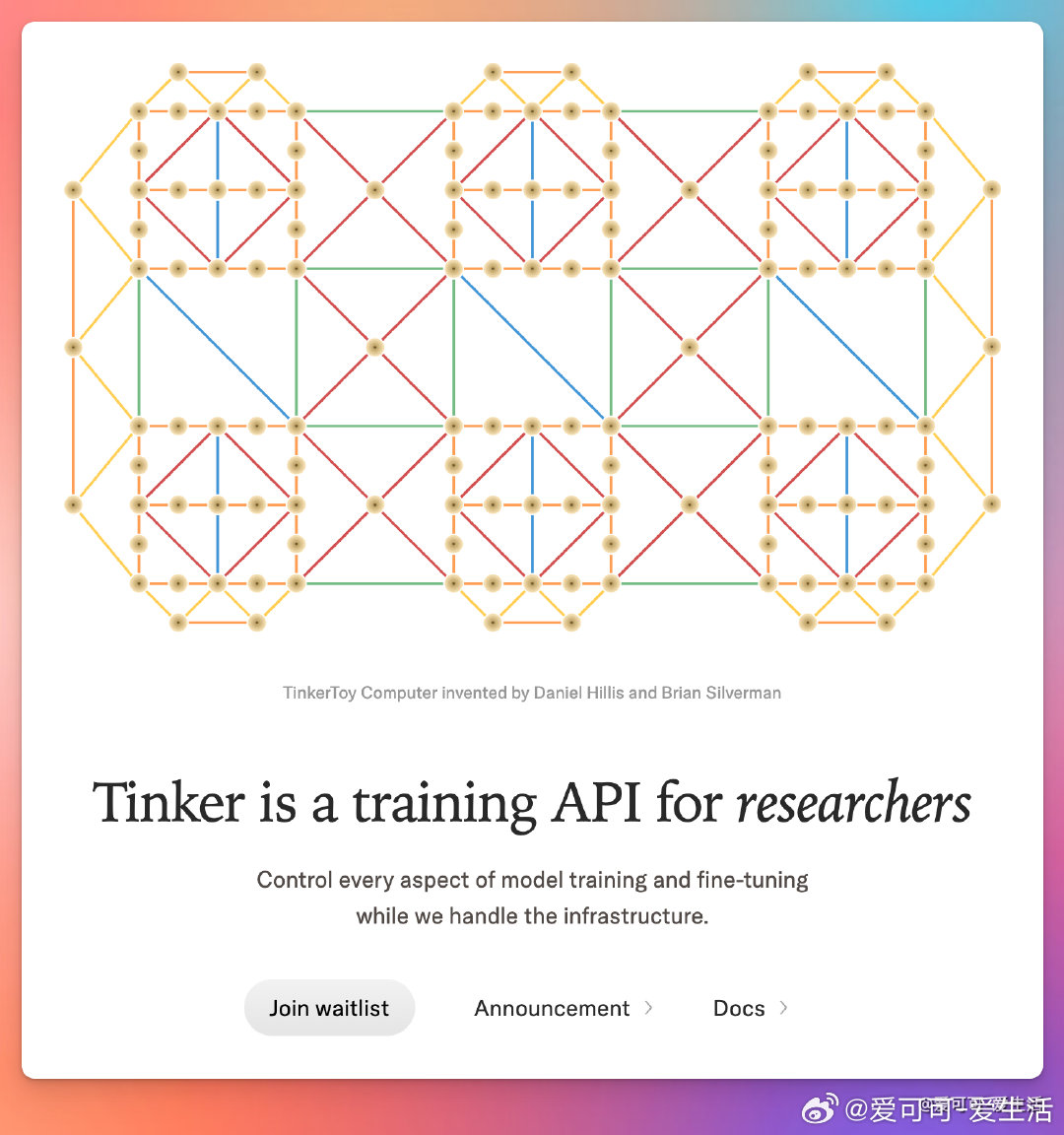

Andrej Karpathy 介绍了 Tinker——一个极大简化大语言模型(LLM)后训练复杂度的工具。研究者和开发者依然保持90%的算法与数据控制权(如数据选择、损失函数、算法设计),而 Tinker 负责处理繁琐的基础设施、前后向传播和分布式训练部分,使得后训练复杂度降到传统方式的十分之一以下。相比传统“上传数据,云端训练”的闭环,Tinker 在降低门槛的同时保护了核心创新自由度。

他指出,目前社区仍需摸索微调(finetuning)相较于依赖大模型提示(prompting)的适用场景和优势。早期观察显示,微调不是为了“风格化”模型,而是用来缩小任务范围,尤其是在训练样本充足时效果明显。典型如分类器、垃圾邮件过滤等狭义场景,微调小模型往往比设计巨型few-shot提示更高效、更快速。未来生产环境中,LLM应用往往是多个模型协作的流水线,部分模块适合提示,更多则适合微调,Tinker让实验和切换变得轻松。

社区反响普遍认可这一思路,尤其是中型企业希望在保证数据隐私和安全的前提下,既能微调也能提示开源大模型,灵活掌控模型和数据;而微调小模型也更适合边缘计算和特定领域规划。还有声音指出,数据质量依然是瓶颈,微调的成功依赖于高质量、结构化的训练数据。

此外,微调的真正价值可能不仅在于任务适配,还在于基于明确评价指标调整目标函数,从而获得性能提升。未来微调模型的流动性和可组合性(如链上交易与共享)也被看作是社区共赢的新方向。

总结来看,Tinker代表了一种智慧的复杂度切分方式:把基础设施复杂度委托给工具,保留数据和算法核心控制,极大降低了微调的门槛,助力小团队和研究者更自由地试验和创新。微调与提示的边界逐渐清晰,针对具体任务选择最优方案,或许将成为未来LLM应用的主流路径。

原推文链接:x.com/karpathy/status/1973468610917179630

Tinker:thinkingmachines.ai/tinker/

![没干过这个事情,说自己喜欢玩switch都没底气[doge]](http://image.uczzd.cn/5909341144242180646.jpg?id=0)