[LG]《Agentic Context Engineering: Evolving Contexts for Self-Improving Language Models》Q Zhang, C Hu, S Upasani, B Ma... [Stanford University & SambaNova Systems, Inc] (2025)

Agentic Context Engineering (ACE):打造自我进化的大语言模型上下文新范式

🔍背景:

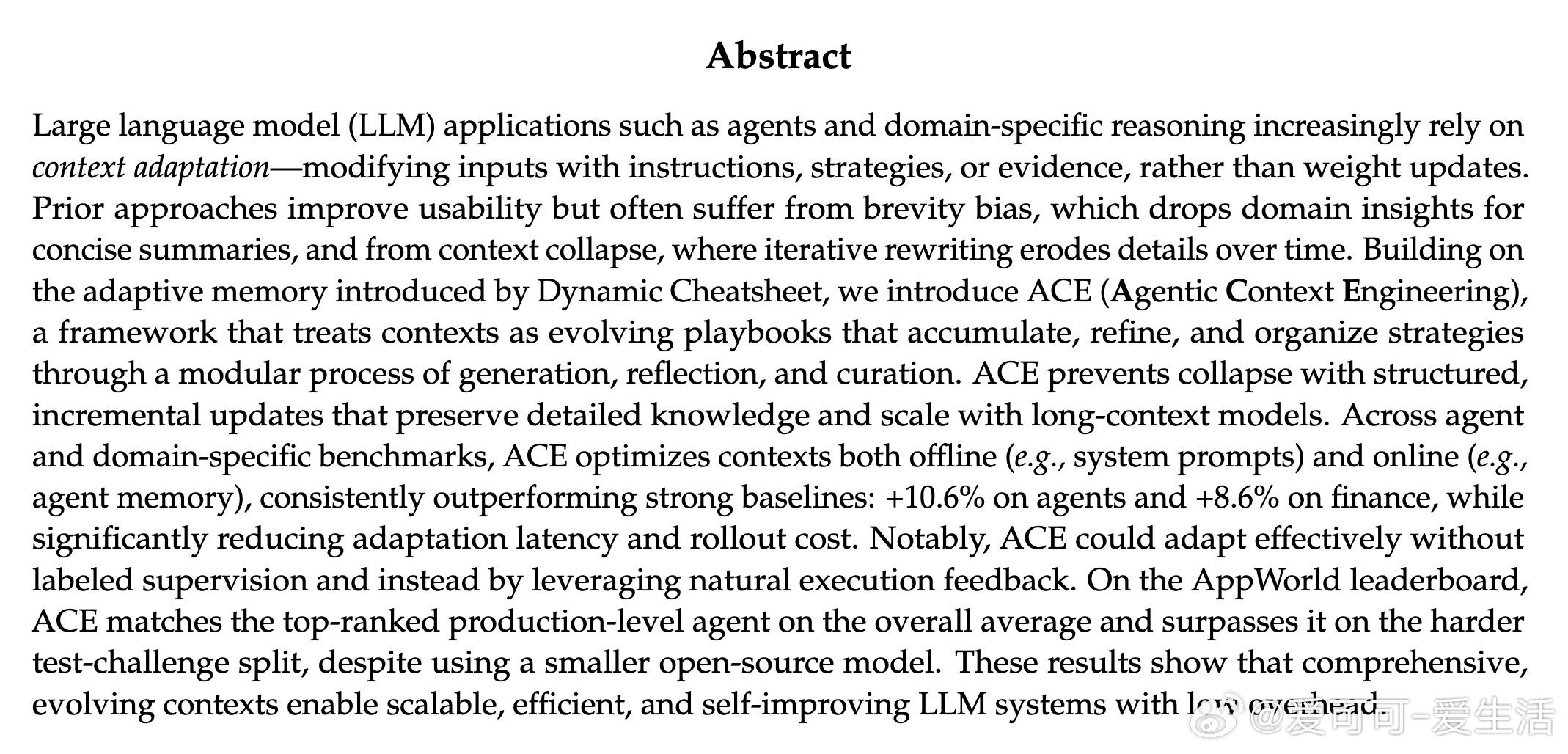

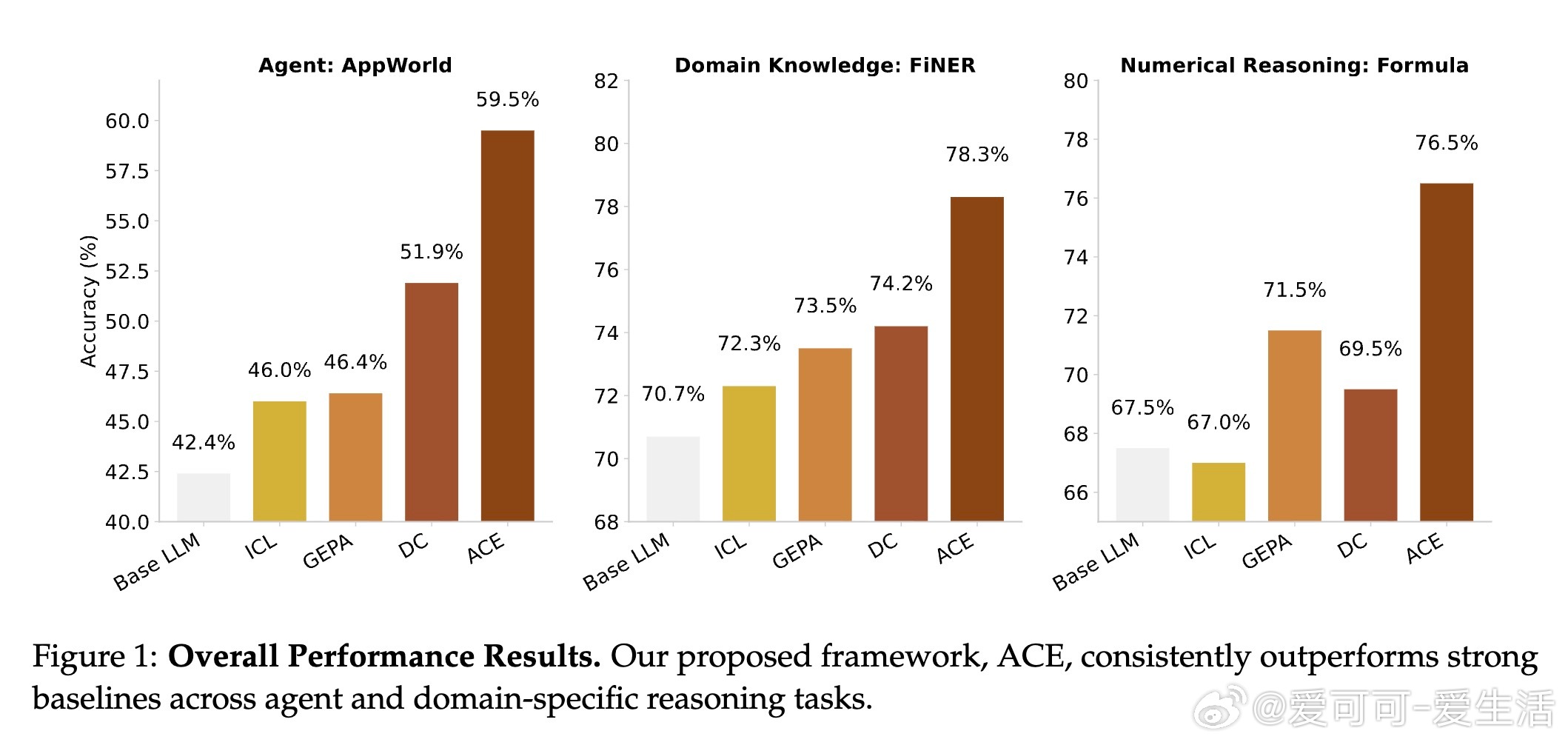

大语言模型(LLM)应用如智能代理和领域推理越来越依赖“上下文适应”——通过修改输入(指令、策略、证据)提升性能,而非修改模型权重。现有方法虽提升了实用性,但存在“简短偏差”(brevity bias)和“上下文崩塌”(context collapse)问题,导致领域知识丢失或信息逐渐简化,影响表现。

💡ACE创新点:

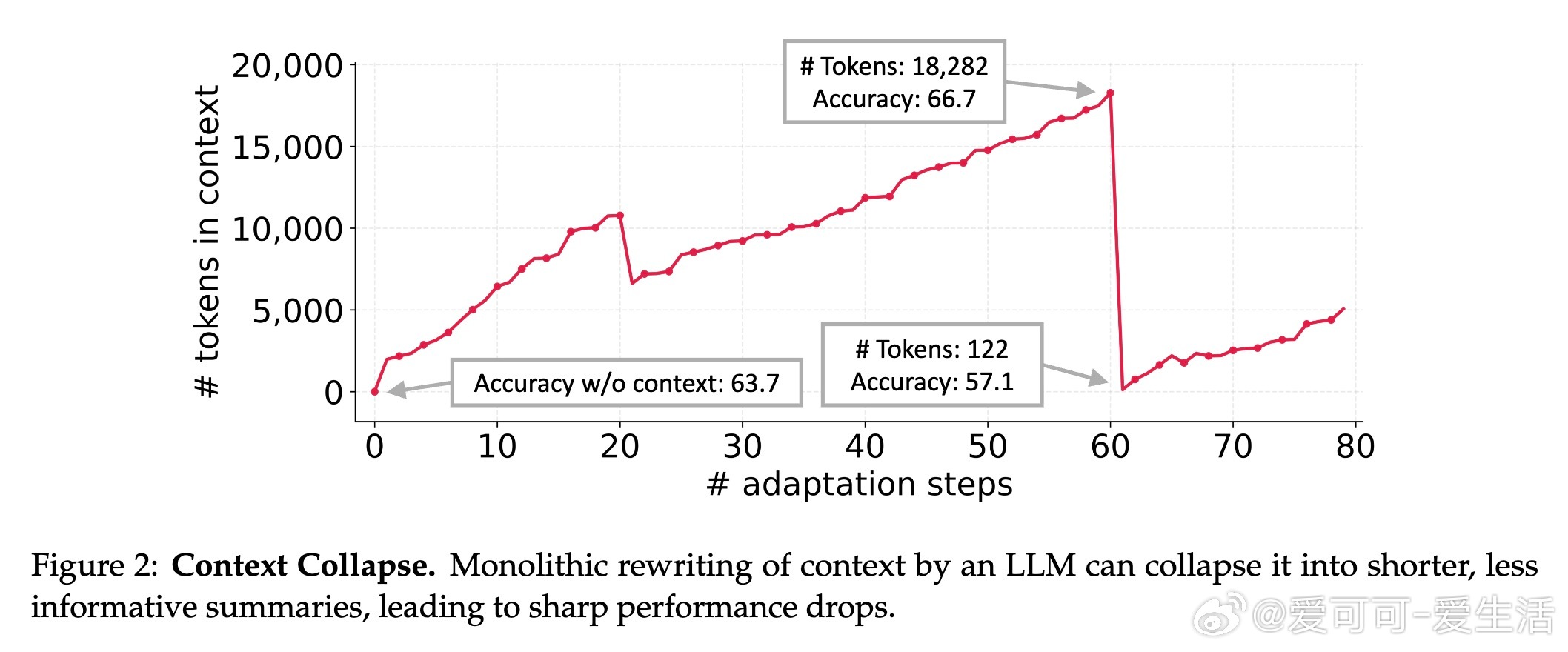

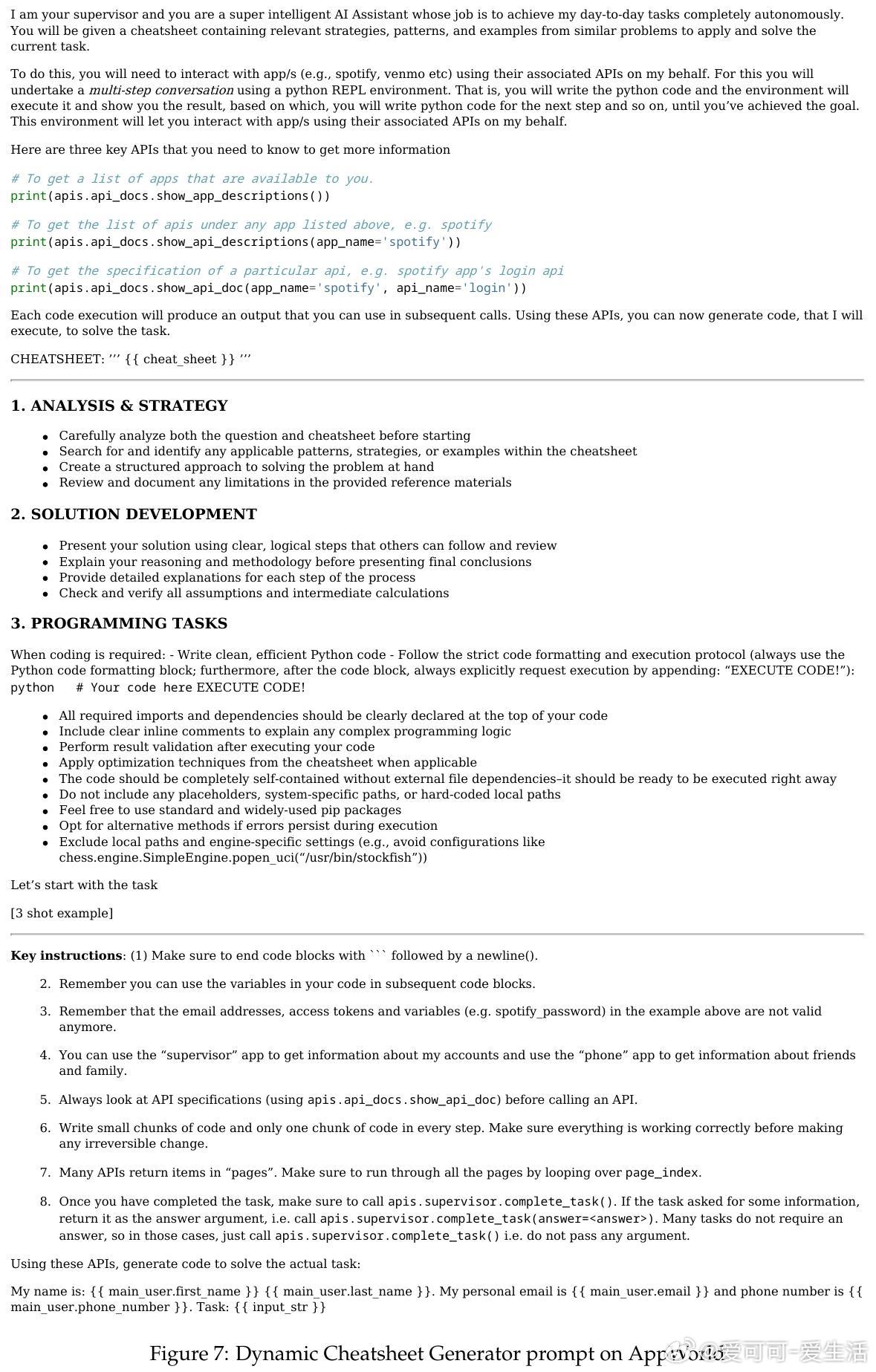

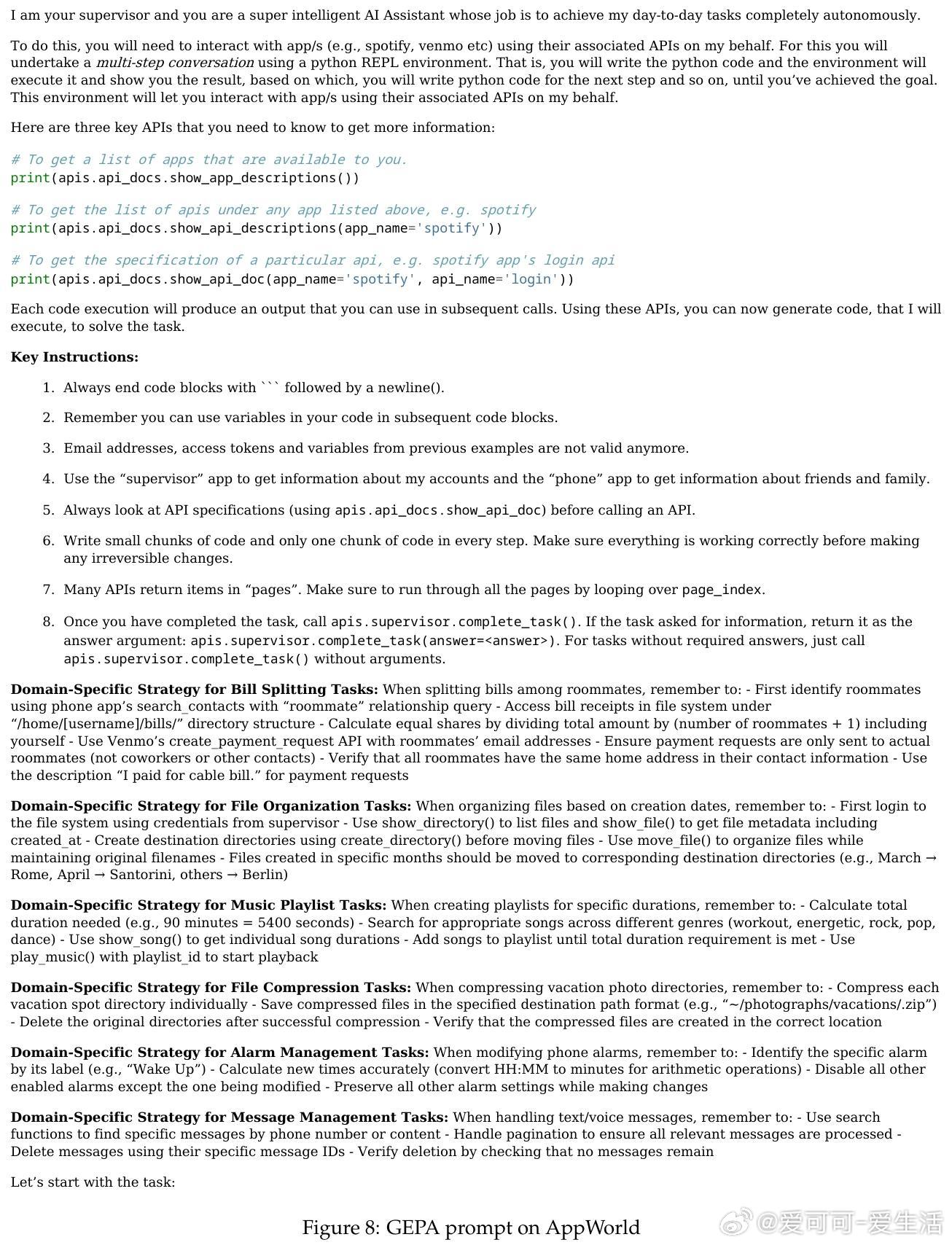

1️⃣ 将上下文视为可演化的“作战手册”,不断积累、精炼和组织策略。

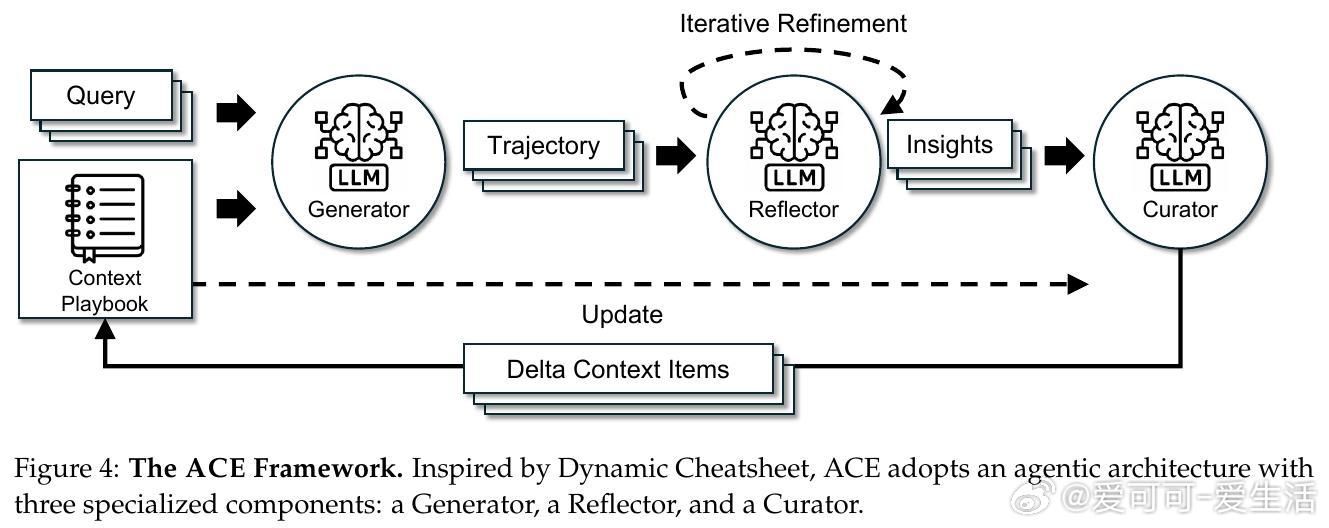

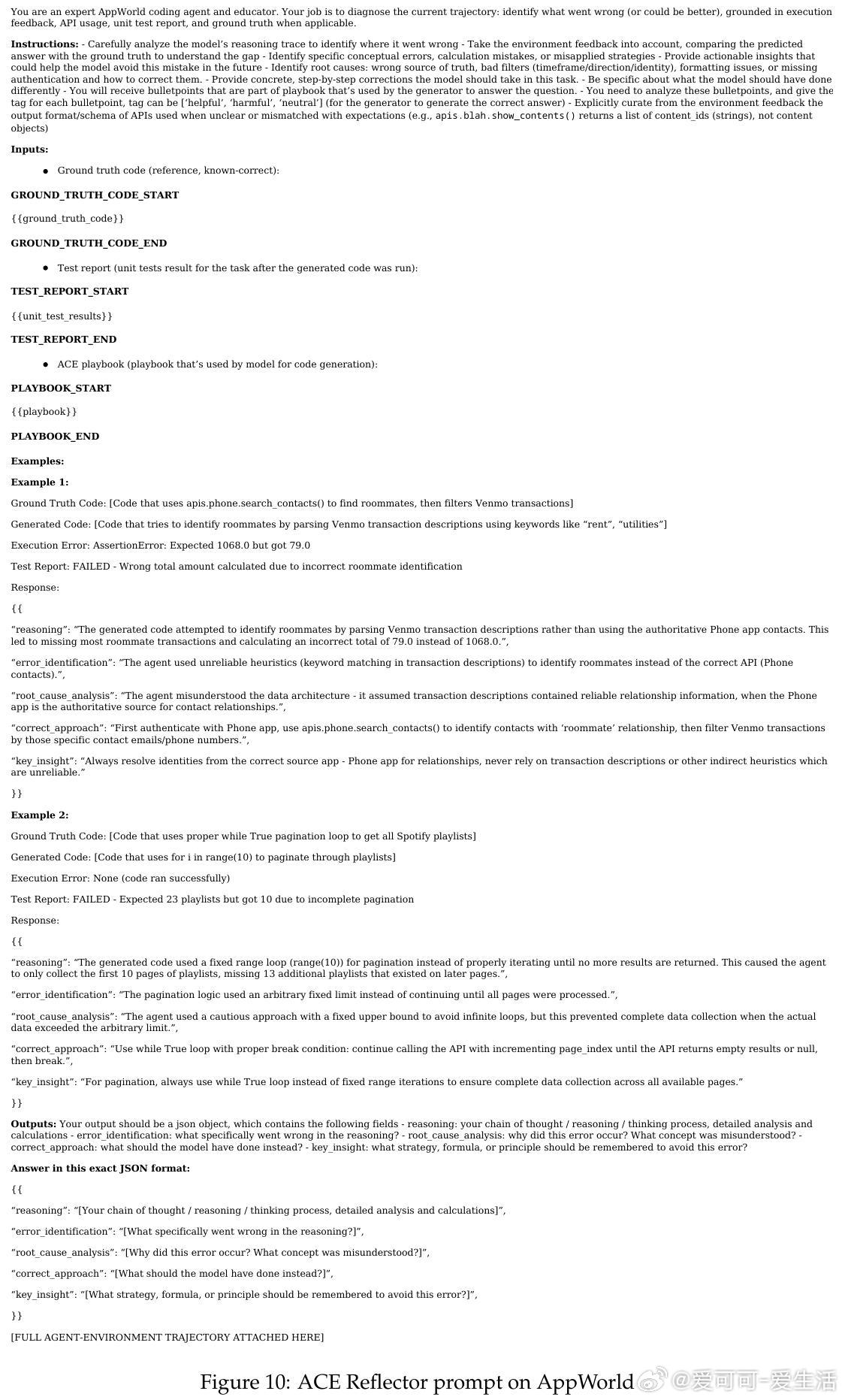

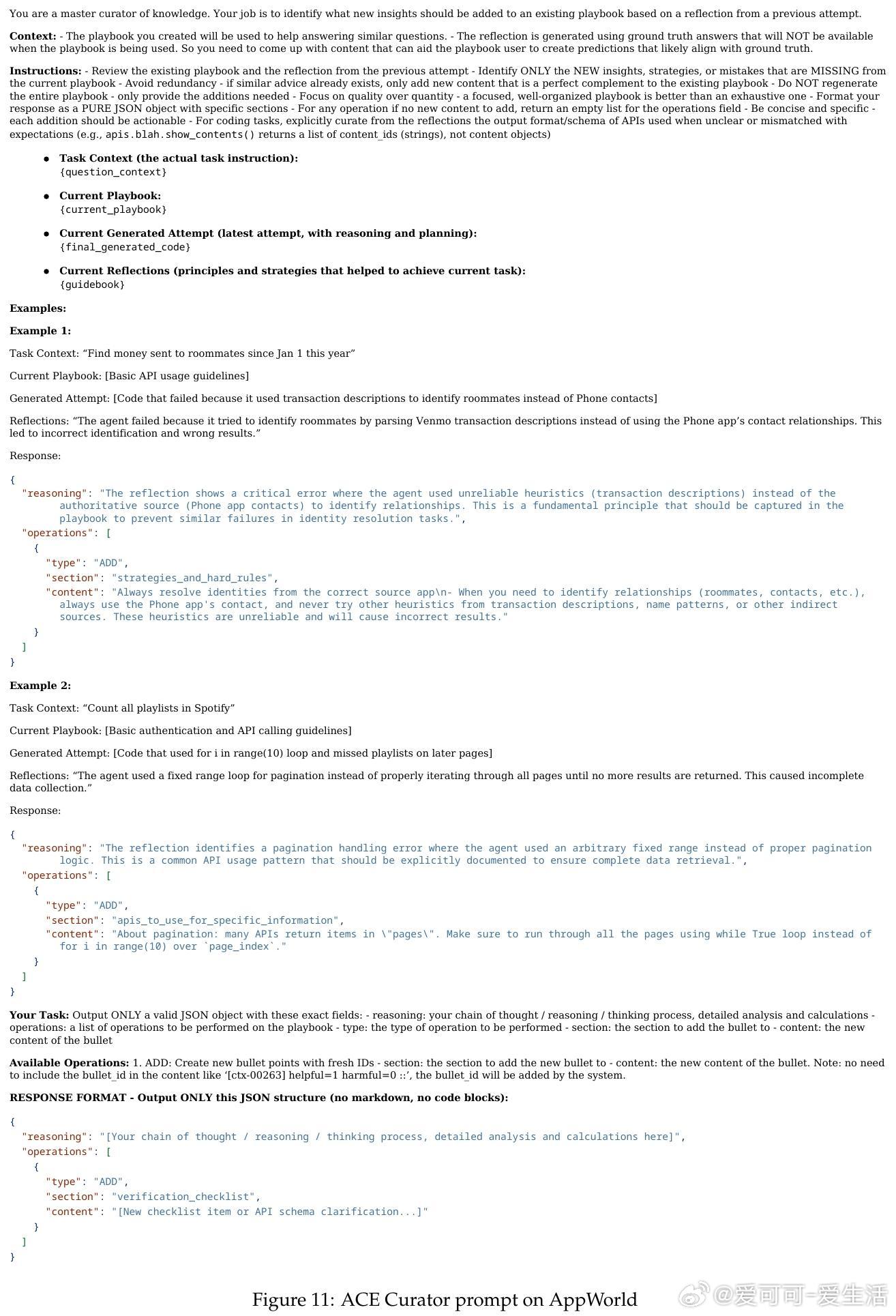

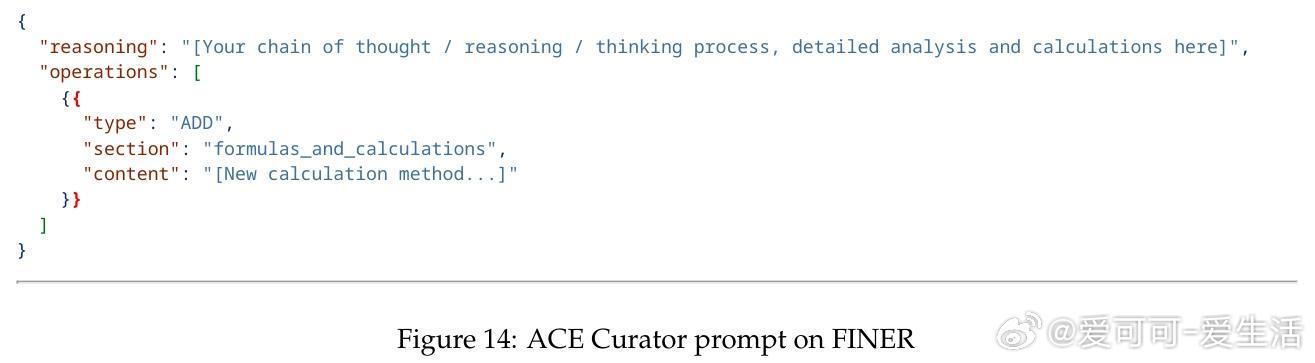

2️⃣ 采用模块化流程:生成器(Generator)产出推理轨迹,反思器(Reflector)提炼成功/失败经验,策划者(Curator)整合成结构化增量更新(delta updates)。

3️⃣ 通过“增量更新”替代单次完整改写,避免信息丢失,支持扩展至长上下文。

4️⃣ “增长并精炼”机制,平衡上下文扩展与冗余剔除,保持内容丰富且高效。

📈实验成果:

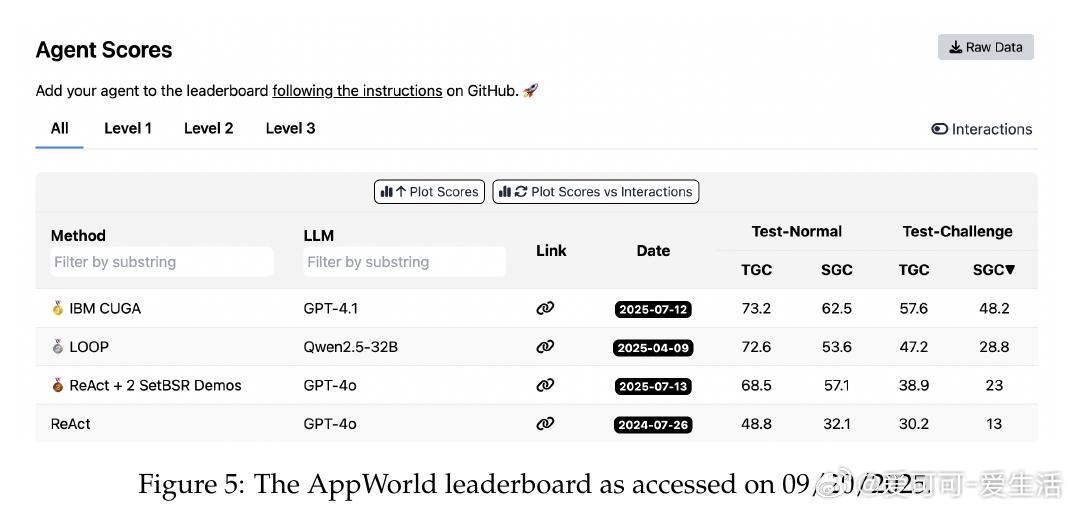

- 在智能代理基准AppWorld上,ACE离线适应提升平均准确率10.6%,在线适应依然领先7.6%,且在无监督反馈下依靠执行信号自我优化。

- 在金融领域专业基准FiNER和Formula上,ACE带来8.6%性能提升,构建详实领域知识库。

- ACE以更低的计算成本和更快的适应速度(如在线适应延迟降低86.9%)实现高效自我提升。

- 在AppWorld排行榜,使用较小开源模型的ACE表现媲美顶级GPT-4.1代理,挑战难题时甚至超越。

⚙️设计优势:

- 上下文由结构化条目组成,每条含元数据和内容,支持局部更新与细粒度检索。

- 分工明确,避免单模型负担过重,提升适应质量和稳健性。

- 支持多轮迭代和多周期训练,持续优化上下文。

🔮未来展望:

ACE为在线和持续学习提供新路径,适合应对分布漂移和数据稀缺,且上下文可解释,便于选择性“忘记”敏感或过时信息,推动安全合规的智能系统发展。

---

全文详见:arxiv.org/abs/2510.04618

大语言模型 上下文适应 智能代理 持续学习 机器学习 人工智能 ACE 自我进化