[LG]《Relational Transformer: Toward Zero-Shot Foundation Models for Relational Data》R Ranjan, V Hudovernik, M Znidar, C Kanatsoulis... [Stanford University] (2025)

迈向关系数据的零样本基础模型

关系型数据库作为企业结构化数据的主力军,因其多表、多属性及主外键复杂联系,长期缺乏可迁移、通用的基础模型。本文提出的Relational Transformer(RT)架构,实现了在多样关系数据库上的大规模预训练,能零样本泛化至未见数据集与任务,无需特定微调或上下文示例检索。

核心创新:

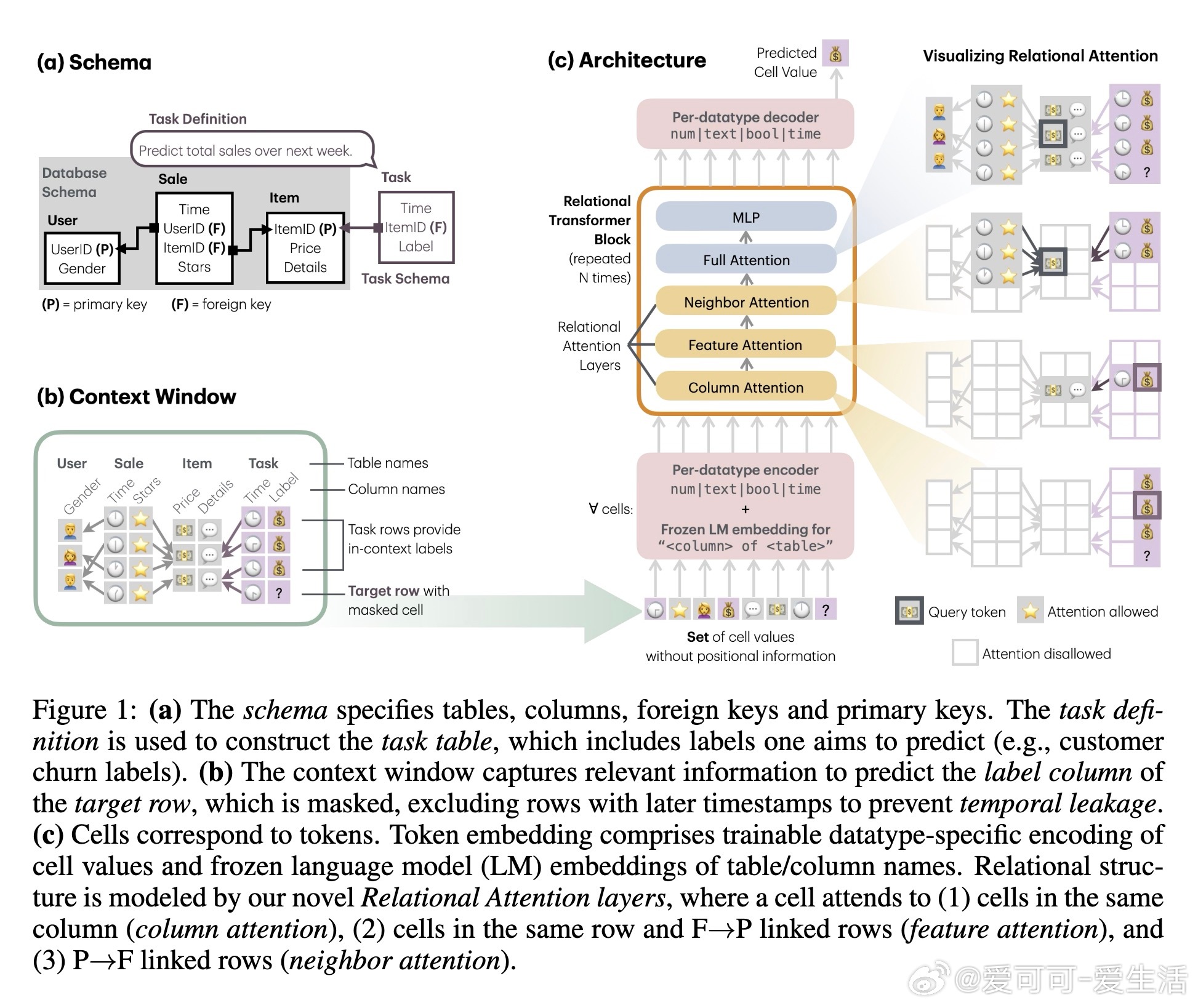

1️⃣ 细胞级Token化:将数据库单元格作为Token,结合表名、列名元信息,实现任务统一为掩码Token预测,支持灵活自监督预训练。

2️⃣ 任务表集成:引入任务表作为输入,带来丰富上下文,支持异构模式间的零样本预测。

3️⃣ 关系注意力机制:设计列注意力(同列分布)、特征注意力(同行及父表关联)、邻居注意力(子表关联)与全局注意力,精准捕获跨表、跨行依赖。

实验结果:

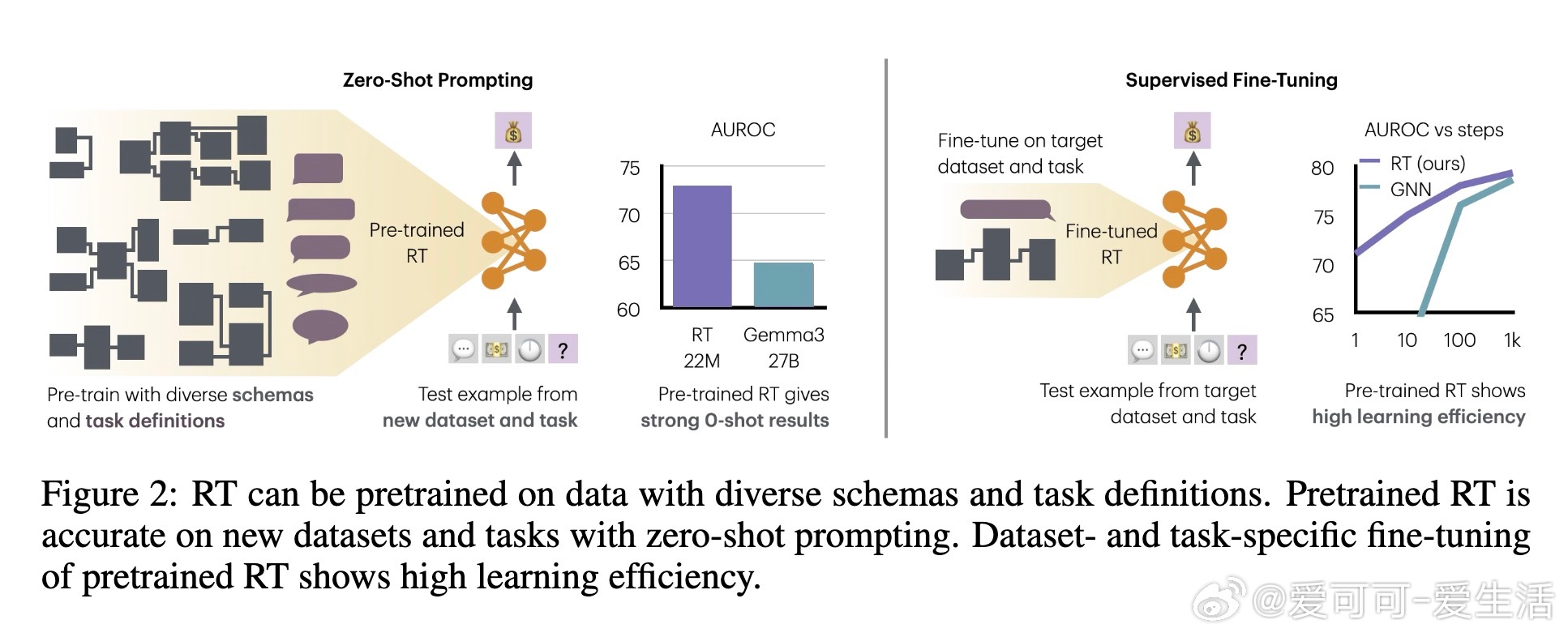

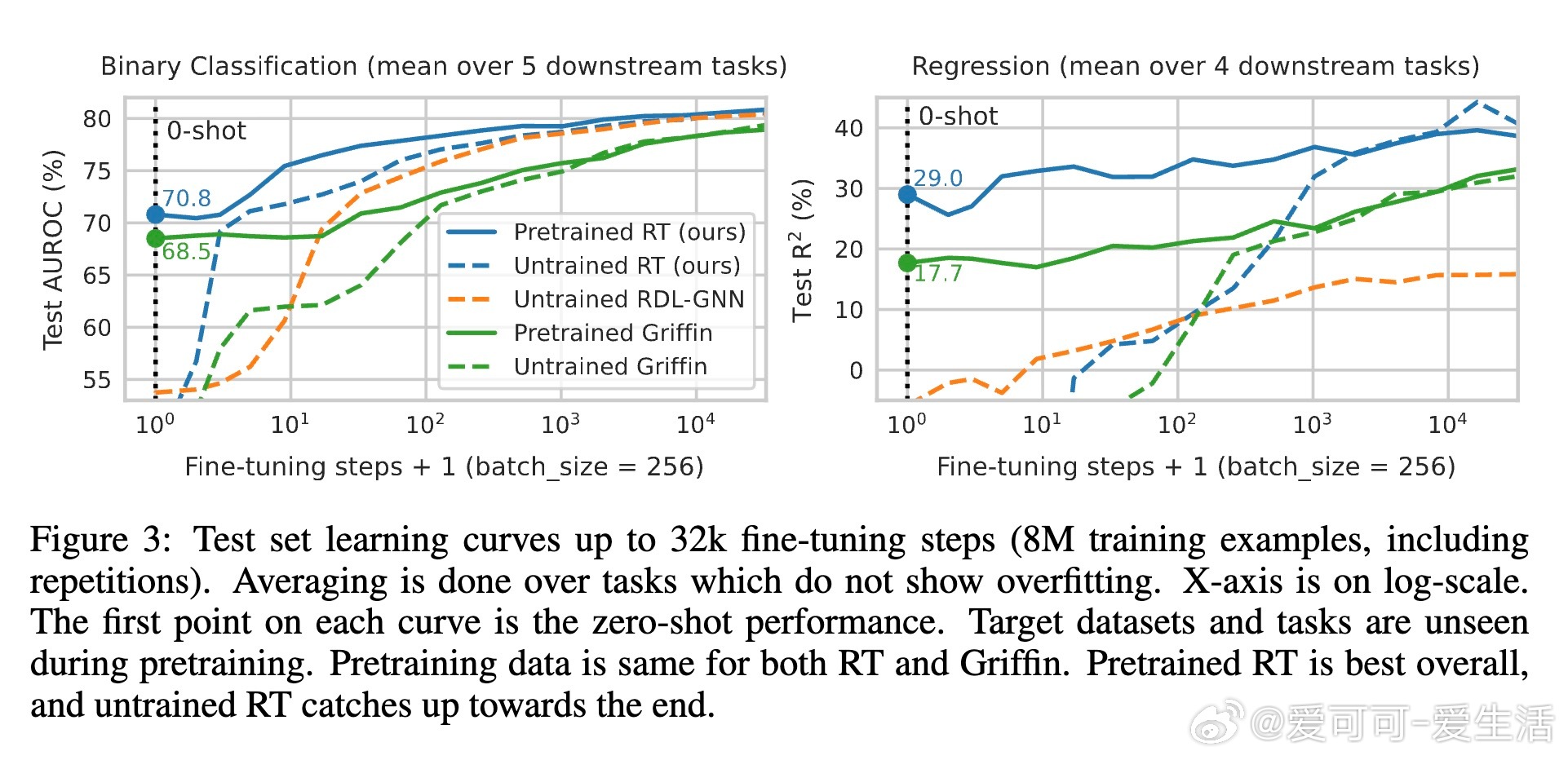

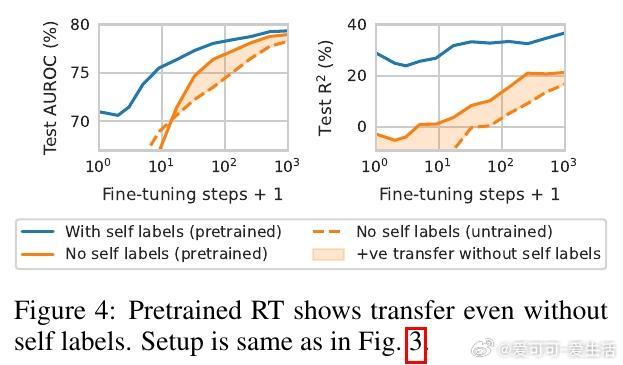

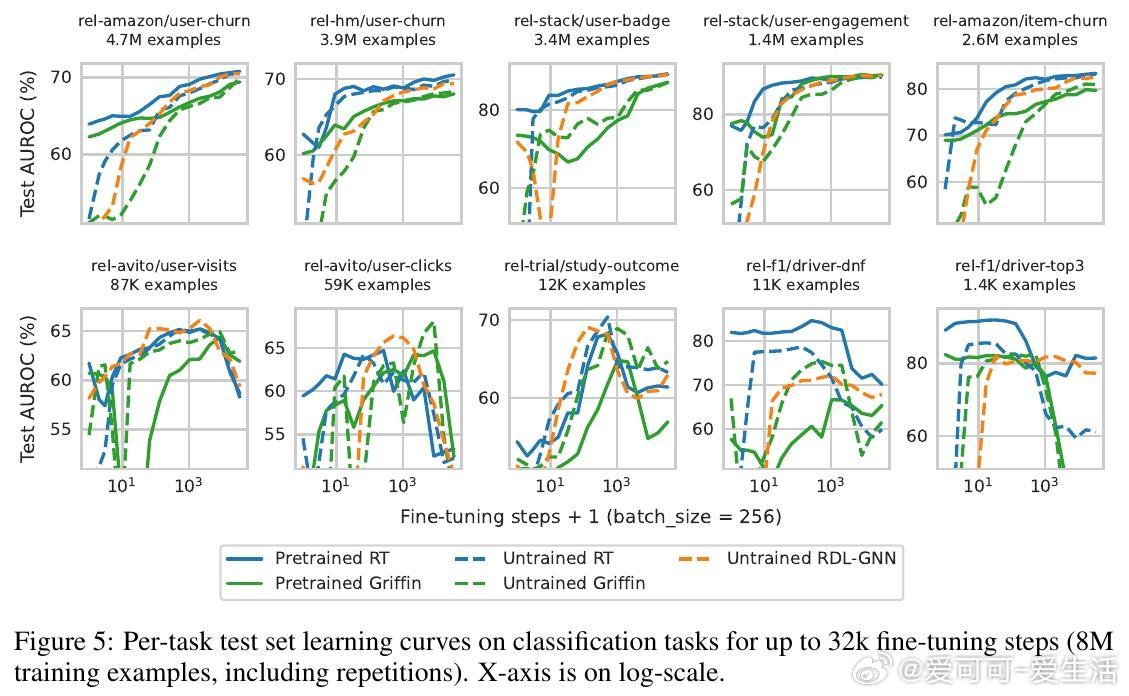

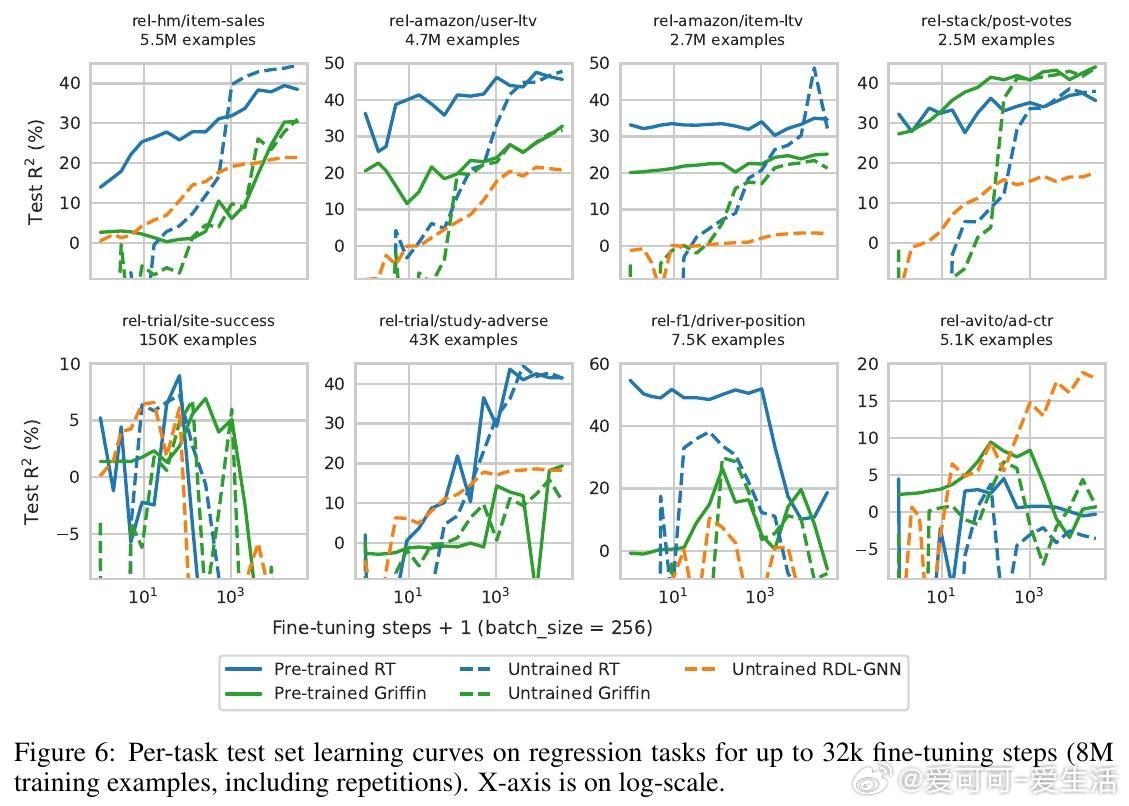

- 在RelBench多领域数据集上,RT零样本二分类任务AUROC达到完全监督学习的94.4%,远超27B参数LLM的84%。

- 微调时表现出卓越样本效率,少量数据即可超越多种基线。

- 消融分析验证,时间序列上下文、关系注意力层及模式语义是零样本迁移的关键。

意义展望:

RT开辟了关系数据基础模型研究新路径,突破传统手工特征工程与模式绑定限制,为企业级AI普及和专家建模提供强力工具。未来工作聚焦推荐系统、链接预测及更丰富编码策略。

论文详阅👉 arxiv.org/abs/2510.06377v1

机器学习 关系数据库 基础模型 零样本学习 Transformer 深度学习